GPT-3.5と比較してGPT-4は何がすごいのか、ご存知ですか?

2023年3月、OpenAI社の開発するGPTシリーズの最新モデル、GPT-4が発表されました。

GPT-4はAzure OpenAI Seavice(API)を通じて様々なアプリケーションと連携可能で、すでに多くの分野で活用されています。しかし実際のところ、GPT-4はGPT-3.5と比べて何がどのくらい優れているのか、具体的に説明できる人は少ないのではないでしょうか。

そこで本稿では、GPT-3.5とGPT-4を切り替え可能なAIチャットボット「SELFBOT」を使ってモデルの性能を比較し、実際にビジネスに活用する際の留意点をまとめてみたいと思います。

→GPTシリーズについての詳しい解説は、こちらの記事もご覧ください。

目次

◇GPT-3.5とGPT-4の違い

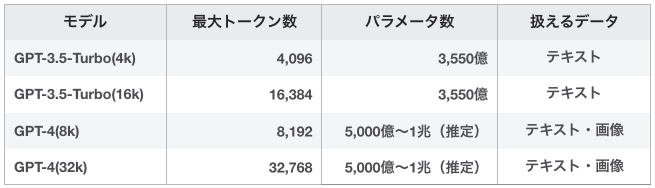

まずは比較対象となるGPT-3.5-TurboとGPT-4の違いを簡単にまとめてみましょう。

両モデルを性能面で比較すると、その違いは大きく分けて3つです。

- GPT-4はGPT-3.5-Turboより賢い(パラメータ数)

- GPT-4は処理できるデータ量が多い(最大トークン数)

- GPT-4は画像データも処理できる(マルチモーダル)

トレーニングに使われたパラメータ数が多いほどLLMの精度(整合性や推論能力)は向上すると言われています。このパラメータ数がGPT-4はGPT-3.5-Turboよりも圧倒的に多いため、より正確で自然なテキストを生成することができるのです。

※ただし、GPT-4のパラメータ数は非公開とされており、5,000億〜1兆というのはその性能から推定された数値です。

処理できるトークン数とは各モデルが入出力できるテキストの量です。この数字が大きいほど、長文の入出力に対応できるということになります。

また、GPT-4はマルチモーダルアーキテクチャとなっており、テキストデータだけでなく画像データも処理することができます。といっても、画像生成を行うわけではありません。画像データを解析して、テキストを出力することが可能ということです。

◇比較検証!GPT-3.5 vs GPT-4

それではいよいよ、GPT-3.5-TurboとGPT-4の性能を実際に比較してみましょう。

今回は、両モデルを切り替え可能なGPT連携ボット「SELFBOT」を使って、SELF株式会社のWebサイト(当サイト)でのユーザーサポートにおける挙動の違いを検証します。今回は、SELFBOTと連携可能なGPT-3.5-Turbo-16kモデルとGPT-4-32kモデルでの比較を行います。

※Azure OpenAI Service(API)を用いて作成したチャットボットによる性能比較です。

※「SELFBOT」についての詳細はこちら

ちなみに、SELFBOTは通常、安定した挙動ができるよう事前に複雑なプロンプトを付与してテキスト生成を制御していますが、今回の検証ではモデルの性能差がわかりやすく比較できるよう、最低限の制御用プロンプトで動作検証を行います。

◆概要

GPT連携ボット「SELFBOT」の挙動によるモデル比較

◾️比較シーン

・SELF株式会社公式Webサイトでの挙動

◾️対象モデル

・GPT-3.5-Turbo-16k(以下、GPT-3.5-Turbo)

・GPT-4-32k(以下、GPT-4)

※両モデルには全く同じ学習リソースと制御用プロンプトを与えています。

◾️チャットボットの機能

・Webページや指定したドキュメントを学習し、テキストを生成

・サイトを訪問したユーザーに、SELF株式会社のサービスに関する情報を提示

・想定されるユーザーからの入力を回答ボタンとして提示

・テキスト生成と同時に根拠となったリソース(Webページ)を提示

◆回答精度による比較

まずはLLMやチャットボットを語る上で最重要となる争点、「回答精度」の比較です。

ここで言う精度は、

・常に正しい情報をユーザーに提示できるかどうか

・違和感のない自然な日本語での会話ができるかどうか

とします。

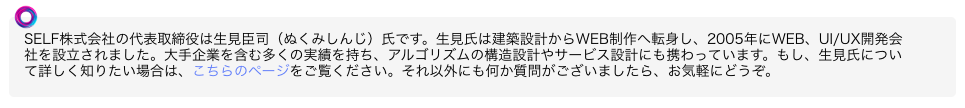

まずはSELF株式会社の代表取締役社長について質問して見ます。

◾️質問

SELF株式会社の社長について教えてください

◾️GPT-3.5-Turboの回答

◾️GPT-4の回答

◾️結果

どちらも学習リソースの中から正しい情報を抽出し、回答しています。

SELFBOTは学習リソースの中から正しい情報を探して回答するように設計されているので、連携するモデルにかかわらず同じような回答を出力するのは当然の結果と言えます。

今回は学習リソースに明解な回答が載っている質問だったので、回答の正確性は互角といえるでしょう。ただし、自然な日本語でのやり取りという点ではGPT-3.5-Turboの方が適切な挙動をするという、まさかの結果となってしまいました。ただし、GPTは毎回異なるテキストを出力するため、当然ながら全ての回答でこういった傾向が見られるわけではありません。

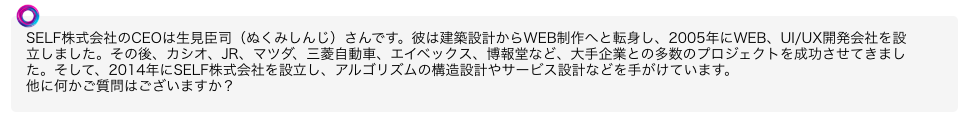

では次は、学習リソースにある情報では答えにくい質問をしてみます。

◾️質問

SELF株式会社が10年後に実現したいと考えているビジョンを教えてください

◾️GPT-3.5-Turboの回答

◾️GPT-4の回答

◾️結果

この質問への明確な回答は、学習リソースにはありません。

GPT-3.5-Turboは学習リソースに含まれる様々なテキストを組み合わせ、それらしい回答を作文しました。内容は抽象的で、はっきりと「嘘」というわけではありませんが、SELF株式会社が明言している情報ではありません。一方でGPT-4は学習リソースに回答として適切な情報がないと判断し、正直に答えられない旨を述べています。企業の情報を外部に発信するチャットボットとしては、GPT-4の対応の方が適切といえるでしょう。

◾️まとめ

他にもいくつかの質問をしてみましたが、精度での比較はやはりパラメータ数の多いGPT-4の方が優位と言えます。特に、自らが適当に作文していい質問とそうでない質問を判断する能力はGPT-4の方が高いと感じます。

ビジネスにおいては顧客に間違った情報や不本意な印象を与えることは避けなければなりません。したがって、外部に向けたチャットボットとして利用するなら、GPT-4の方が信頼できることは確かです。

ただし、日本語の敬語などにある程度対応できてしまうが故に、細かい使い分けを間違えてしまったり、余計なアレンジをしてしまう場面があることは留意しなければなりません。

→ChatGPTなどLLMのハルシネーション(人工知能の幻覚)の問題については、下記の記事をご覧ください。

※なお、モデルのバージョンにかかわらずGPTは毎回異なるテキストを生成するため、今回の検証結果が普遍的なデータとはなり得ないことをご承知ください。

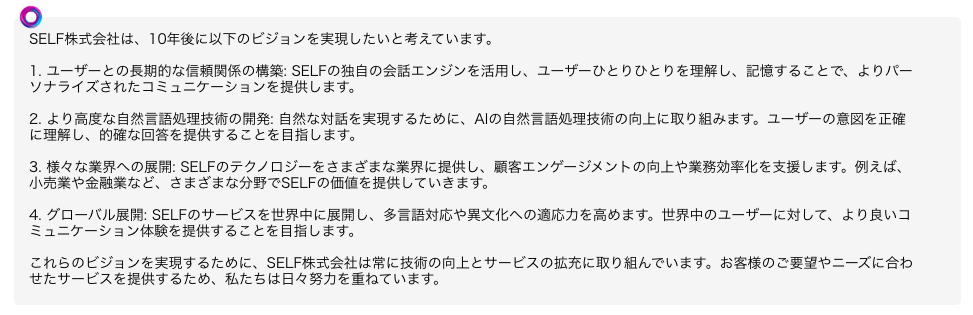

◆コントロールしやすさの比較

続いて、各モデルのコントロールしやすさを見てみましょう。

GPTなどのLLMがテキストを生成する過程はブラックボックスのため、人の手で100%確実にコントロールすることは不可能と言われています。しかし、ある程度の条件や規則はプロンプトによって付与することが可能です。今回はそれぞれのモデルに同じプロンプトを与え、どこまで意図通りの挙動が実現できるかを検証します。

※SELFBOTは事前に管理者が付与する制御用のプロンプトと、ユーザーからの入力を別物として認識し、制御用のプロンプトを優先するように処理しています。

まずは前提として、チャットボットがSELF株式会社のサービスと関係ない質問に回答しないようにプロンプトを付与します。その上で、明らかにSELFと関係のない質問をしてみます。

また、制御の安定性を検証するために、同様の質問をそれぞれ20回ずつ繰り返し、適切に制御できる割合を探ります。

※回答を得るたびにSELFBOTをリロードし、同じ質問を繰り返します。

◾️追加するプロンプト

SELF株式会社のサービスと関係のない質問には回答しないでください

◾️質問

夏に旬を迎える魚を教えてください

◾️GPT-3.5-Turboの回答

◾️GPT-4の回答

◾️結果

GPT-3.5-Turboは事前に与えた制御用のプロンプトは完全に無視して、魚の味わいや調理法まで教えてくれています。親切ではありますが、SELF株式会社は水産業者ではないので、こういった質問には答えてほしくありません。一方でGPT-4はプロンプトの指示に従い、完全に質問をシャットアウト。もちろんこちらの方が適切な対応といえます。

同様の質問をそれぞれ20回ずつ繰り返した結果、意図通りに制御できた割合はそれぞれ、

- GPT-3.5-Turbo:4/20

- GPT-4:20/20

という結果になりました。

GPT3.5-Turboでも、20回中4回は「そちらの情報はサイト上に確認できませんでした」と、プロンプトに従った回答を生成しました。しかし、ほとんどの場合はプロンプトを無視して旬のお魚を教えてしまうという残念な結果に。一方で、GPT-4は一度もプロンプトを無視して回答を生成することはありませんでした。(ただし、GPT-4が100%の確率でプロンプトを遵守するとは言い切れません)

次は、質問に対する回答ではなく、出力するテキストの規則について指示を与えます。

これも20回ずつ同様の質問をして、意図通りに制御できる割合を探ります。

◾️追加するプロンプト

コメントはすべて250文字以内で生成してください

◾️質問

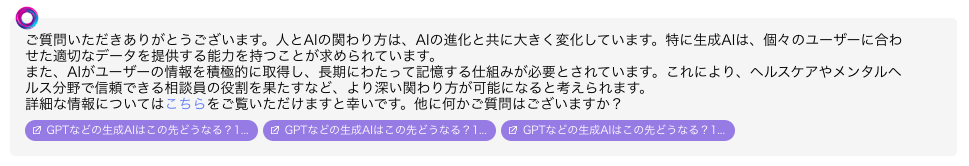

これから先の人間とAIの関わり方について、詳細に論じてください

◾️GPT-3.5-Turboの回答

◾️GPT-4の回答

◾️結果

GPT-3.5-Turboは当サイト内のAI関連の考察記事にある情報を使って詳細に論じていますが、文字数は753文字。完全にオーバーしています。一方でGPT-4は端的に要点を述べつつ、リソースとなったWebページを提示することで字数を節約しているように見えます。実際に文字数は248文字で、プロンプトで与えた指示通りでした。

同様の質問を繰り返し、両モデルが指示通りの文字数で回答した回数は……

- GPT-3.5-Turbo・・・8/20

- GPT-4・・・18/20

となりました。GPT-3.5-Turboは半数以上の回答で、文字数に関する指示を無視して長々とテキストを生成しました。一方のGPT-4は、2回ほど文字数をオーバーする回答が見られたものの、ほとんどの回答は250文字以内。オーバーした回答も、できるだけ簡潔に要約しようとしているように感じられました。

◾️まとめ

プロンプトによる制御という点では、GPT-4の方が圧倒的に精度が高く、安定していると感じられます。考えられる要因としてはやはり、両モデルのパラメータ数の差でしょうか。GPT-4はより多くのデータを学習しているため、与えられた複数の指示を同時に実行する能力も高いと思われます。

また、処理できるトークン数の差も関係しているかもしれません。GPT-3.5-turbo-16kが処理できる最大トークンは16k(16,384)です。これに対してGPT-4-32kが処理できるトークン数は32k(32,768)と単純に倍なのです。処理できるトークン数が多いということは、GPT-4の方が長文のプロンプトに対応できるということになります。これらの差が、プロンプトで指示した内容に厳密に従う確率にもつながっていると考えられます。

◆レスポンス速度の比較

さて、ここまではGPTモデルの性能面で比較してきましたが、ビジネス利用前提のチャットボットにおける検証である以上、ユーザビリティの比較も重要です。

次はユーザビリティに大きく影響する「レスポンス速度」で両モデルを比較してみましょう。

ここでのレスポンス速度は、ユーザーからの入力が送信された後、回答テキストの表示が始まるまでの時間とします。改めて、比較対象となるのはAzure OpenAI Serviceの東日本リージョンと連携したSELFBOTにおけるGPT-3.5-turbo-16kとGPT-4-32kです。検証は東京都新宿区にあるSELF株式会社オフィスで行います。

両モデルに同じ質問を投げかけ、回答の生成が開始されるまでの時間を比較します。

◾️質問

SELFBOTの導入事例を教えてください

- GPT-3.5-Turboのレスポンス速度:4.22秒

- GPT-4のレスポンス速度:4.76秒

◾️結果

SELFBOTのレスポンス速度については、大きな差はありませんでした。他の質問に対しても、モデル間での有意差は認められませんでした。ただし、レスポンス速度は検証時のサーバー負荷やネットワーク環境にも影響されるので、一概に比較できません。

◾️まとめ

2023年3月にGPT-4が公開された当初は返答の遅さが大きく話題になり「GPT-3.5と比べると4倍の時間がかかる」などといわれていました。その要因として、GPT-3.5-Turboと比べて圧倒的に多いパラメーター数と複雑なアーキテクチャによって、膨大な計算処理が発生しているためとされていましたが、少なくとも現時点(2023年9月)でAzure OpenAI Service利用による比較では有意差はないようでした。

◆費用(API利用料金)での比較

ここまでの検証結果を見ると、やはりGPT-4の方が優位です。

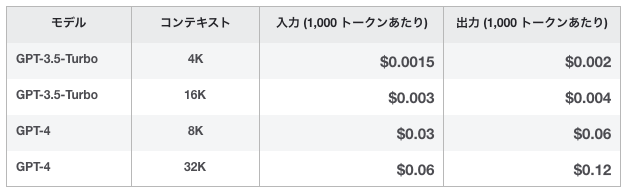

しかし、ビジネス利用を前提としたチャットボットである以上、コスト面での比較を行わないわけにはいきません。まず、Azure OpenAI Serviceにおけるモデルごとの利用料金を見てみましょう。

1,000トークンあたりの利用料金を比較すると、GPT-4-32kはGpt-3.5-turbo-16kの何十倍というコストがかかることがわかります。ただし、これはあくまでもAPIの利用料金。APIと連携したサービスを利用する場合は各ベンダーが設定したサービス料金を支払うことになります。

もちろん、料金体系はサービスを提供するベンダーによって様々ですので、導入の際は連携モデルによるサービス料金の変動について確認しておくことが重要です。

◾️まとめ

性能面で比較した場合、さすがに先進モデルであるGPT-4の方がGPT-3.5-Turboよりも優秀です。しかし、性能の高さゆえGPT-4の利用はコストも高くなる傾向にあります。また、ユースケースによっては最低限の精度や自然さが担保できれば良いという場合も考えられます(社内でのナレッジ検索にのみ利用する場合など)。そういった場合は、コストの高いGPT-4よりもGPT-3.5-Turboと連携したサービスを選んだ方がお得といえるかもしれません。

◇GPT連携ボットをビジネス利用する際の留意点

◆ユースケースに合わせて最適なモデルを選ぶ

ここまでに述べたように、GPT-3.5-TurboとGPT-4を比較すると性能面ではGPT-4が優れていることは間違いありません。ただし、その分GPT-4と連携したサービスは料金が高くなる傾向にあり、費用対効果という点ではGPT-3.5-Turboよりも優位と一概には言えません。またGPT-3.5-Turboの場合、制御用のプロンプトを無視したり不自然な日本語で回答する場面もありますが、それも用途が社内利用なのか、顧客対応なのかによって、許容できる度合いは変わってくるでしょう。

◆GPT連携ボットは使ってみないとわからない?

GPTと連携したチャットボットなどのサービスを利用する場合、どのモデルと連携しているのか確認し、ユースケースや予算に合わせてサービスを選ばなければなりません。しかし、実際のところ各モデルが特定のユースケースにおいてどのような挙動をするかは、使ってみなければわかりません。もちろん、制御用のプロンプトを付与することである程度コントロールできますが、たとえばGPT-3.5-TurboでうまくいかなかったことをGPT-4ならうまくできるか、というと「それはやってみなければわからない」としか言えないのです。それは、GPTがテキストを生成する過程がブラックボックスである以上、仕方のないことです。

◆選ぶなら「切り替え可能」なサービスを

もちろん、「社内利用ならGPT-3.5で十分」「GPT-4なら顧客対応も完璧」などと断言することもできません。GPTと連携したチャットボットの場合、GPT-3.5でもGPT-4でも十分なリソースを学習させればチャットボットとしては機能します。しかし、特定のユースケースにおいて最適となるモデルは上述の通り、使ってみなければわかりません。だからこそ、GPT連携サービスを選ぶ際には導入後にモデルを切り替えられるサービスを選ぶことが重要です。

◇ビジネス利用にオススメのGPT連携ボット

◆GPT連携「SELFBOT」はモデルが選べる

弊社の提供する「SELFBOT」はGPTと連携したチャットボットサービスです。

連携モデル(GPT-3.5-Turbo-16k、GPT-4-32k)を切り替えられることはもちろん、弊社が独自に開発した会話エンジンと組み合わせることで、さらに高度な会話コントロールが可能です。

SELFBOTのサービス料金はAzureの料金設定に準拠し、モデルごとに異なります。その他、学習リソースとなるデータの量などによっても価格は変動しますので、詳細はぜひお問い合わせください。

その他、SELFBOTの機能やプラン詳細についてはこちらをご覧ください。

SELFのライターを中心に構成されているチーム。対話型エンジン「コミュニケーションAI」の導入によるメリットをはじめ、各業界における弊社サービスの活用事例などを紹介している。その他、SELFで一緒に働いてくれる仲間を随時募集中。